SEO-Ranking-Faktoren 2016: Die Searchmetrics-Studie im Überblick

Seit 2012 liefert Searchmetrics im Rahmen einer jährlichen Studie fundierte Analysen rund ums Suchmaschinen-Ranking. Doch die auf den Marktführer Google zugeschnittenen Ranking-Faktoren erschienen Ende 2016 in dieser Art das letzte Mal. Der weltweit agierende Anbieter der gleichnamigen Search- und Content-Performance-Plattform erklärt die Ära allgemeiner SEO-Checklisten für beendet und wendet sich einem differenzierteren Ansatz der Suchmaschinenoptimierung zu. Künftig wird der bisher jährliche SEO-Report des Unternehmens branchenspezifische Analysen umfassen.

Grund dafür ist u. a. Googles KI-System RankBrain, das dank maschinellem Lernen deutlich flexibler agiert als klassische Suchalgorithmen. Erst im Juni 2016 gab Google-Mitarbeiter Jeff Dean gegenüber Technikredakteur Steven Levy bekannt, dass RankBrain künftig in die Bearbeitung aller Suchmaschinenanfragen involviert sein wird. Levys Bericht auf Backchannel zufolge gehört das KI-System heute zu den drei wichtigsten Faktoren im Rahmen des Suchmaschinen-Rankings.

Mit der aktuellen Studie „Rebooting Ranking-Faktoren Google.de“ präsentiert Searchmetrics zwar nach wie vor einen Katalog an Faktoren, die mit der Platzierung in der Suchmaschine korrelieren. Die Untersuchungsergebnisse verstehen sich jedoch in erster Linie als Richtwerte für individuelle, branchenbezogene Analysen. Wie in den Vorjahren basiert die Studie auf einem Set aus 10.000 suchmaschinenrelevanten Keywords. Aktuelle Befunde wurden mit Blick auf vorhergehende Untersuchungen interpretiert. Wir haben die wichtigsten Ergebnisse der Searchmetrics-Studie für Sie zusammengefasst.

Content-Faktoren

Bestärkt durch die jüngsten Änderungen am Google-Kernalgorithmus steht für Searchmetrics fest: Der Content einer Website muss bei der Optimierung für die Suchmaschine im Mittelpunkt stehen. Ein zentraler Faktor ist dabei die Content-Relevanz. Diese wird 2016 erstmals als eigener Ranking-Faktor gewertet. Die Suchmaschinenoptimierung auf einzelne Keyword hingegen verliert zugunsten einer holistischen Textgestaltung deutlich an Bedeutung.

Die Content-Relevanz wird zum zentralen Ranking-Faktor

Guter Seo-Content zeichnet sich dadurch aus, dass er der Nutzerintention entspricht. Diese unterscheidet sich jedoch von Suchanfrage zu Suchanfrage. Content-Marketer stehen somit vor der Herausforderung, möglichst viele Nutzerfragen so gut es eben geht mit ein und demselben Text zu beantworten. Eine Strategie im Rahmen der Content-Erstellung stützt sich daher auf holistische Texte, die verschiedene Teilaspekte eines Themas berücksichtigen und auf unterschiedliche Keywords eines semantisch zusammenhängenden Themenfeldes optimiert werden. Holistischer Content zielt somit darauf ab, gute Suchergebnispositionen für mehrere relevante Keywords zu erzielen. Das einzelne Keyword hingegen rückt in den Hintergrund.

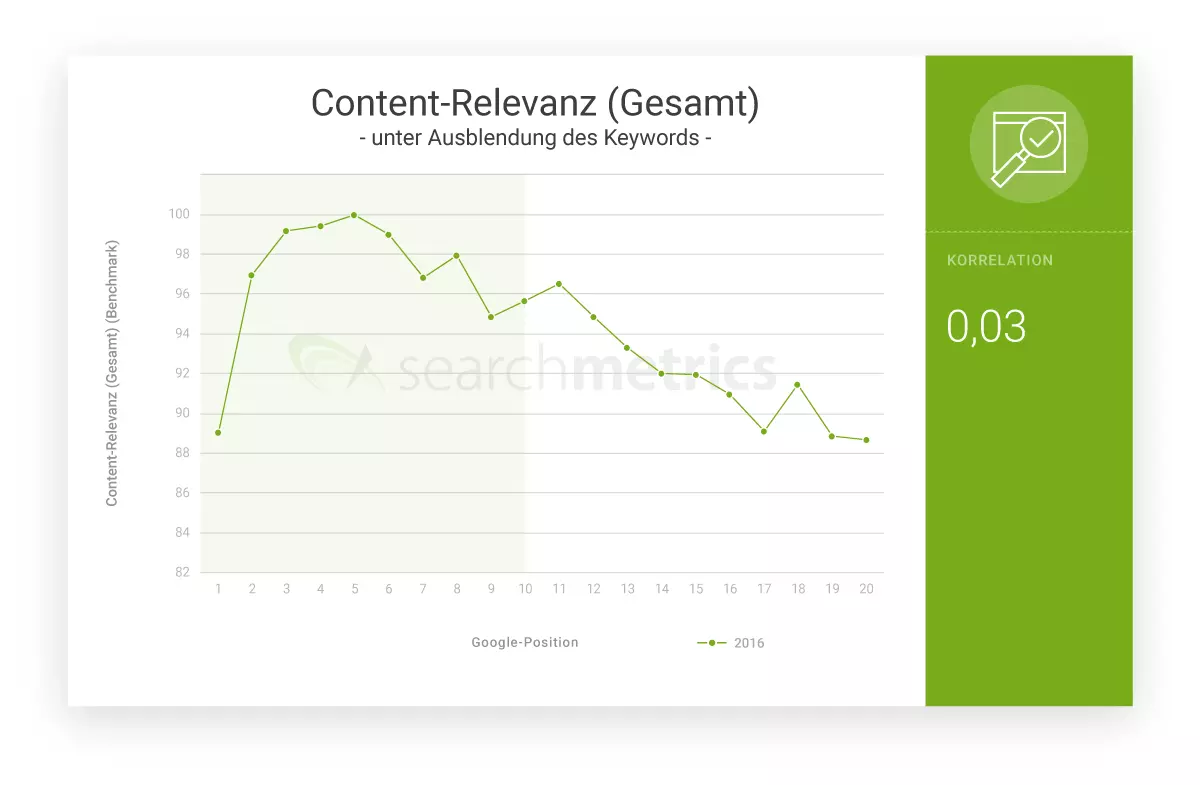

Im Rahmen der Searchmetrics-Studie wurde die Content-Relevanz eines Textes im Verhältnis zum verwendeten Suchbegriff analysiert. Dies geschah auf Basis linguistischer Korpora und der Konzeptionierung semantischer Beziehungen. Das Ergebnis ist wenig überraschend:

„Die höchste Content-Relevanz haben URLs auf den Positionen 3 bis 6.“

Für nachfolgende Suchergebnisse nimmt der Relevanz-Score konstant ab. Die Positionen 1 und 2 müssen im Rahmen dieser Untersuchung gesondert betrachtet werden. Laut Searchmetrics finden sich dort in der Regel bekannte Brand-Websites, die im Google-Ranking von Brand-Faktoren wie Erkennbarkeit, Nutzervertrauen und Brand-Image profitieren, ihre Position jedoch nicht zwingend der Content-Relevanz verdanken.

Die durchschnittliche Wortanzahl steigt

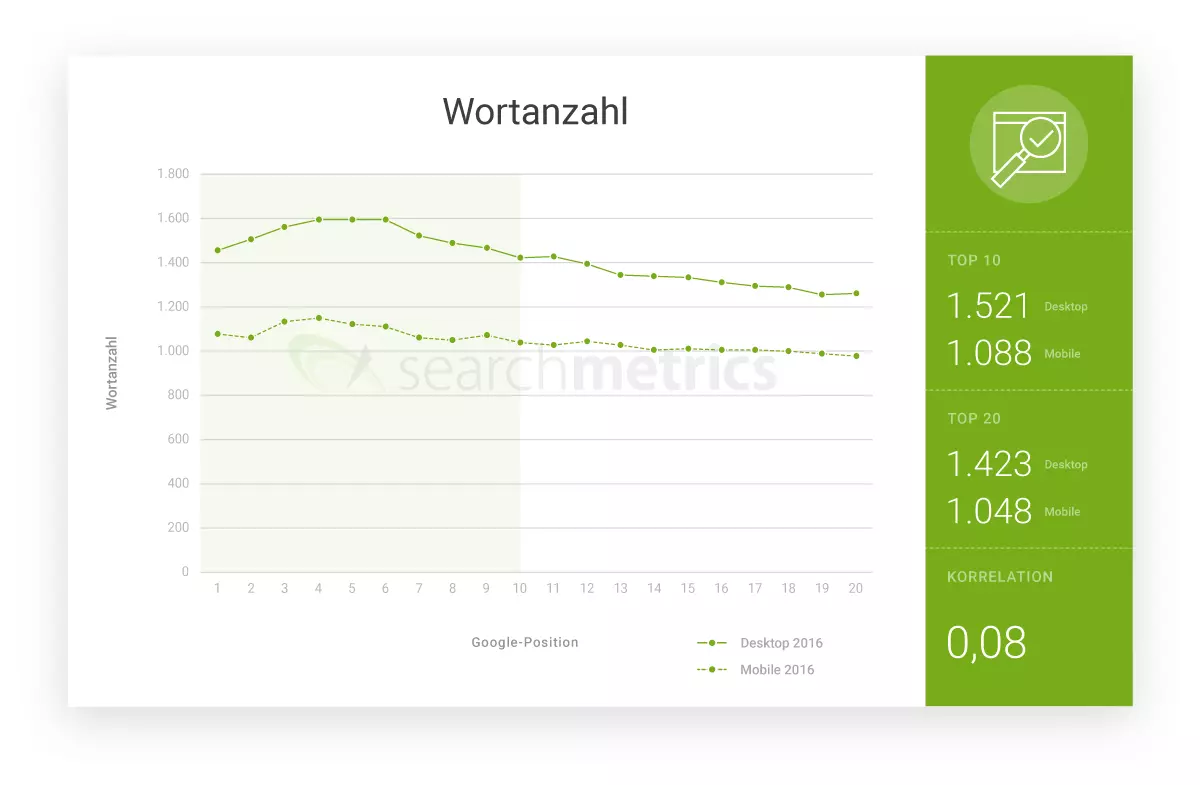

Die durchschnittliche Wortanzahl gut rankender Landingpages nimmt seit Jahren stetig zu. Laut Searchmetrics spiegelt das eine intensivere Auseinandersetzung mit den jeweiligen Themenfeldern im Sinne einer holistischen Content-Erstellung wider.

„Die durchschnittliche Wortanzahl ist 2016 um 50 Prozent gestiegen.“

Deutliche Unterschiede in der Wortanzahl offenbart der Vergleich von Desktop-Inhalten und mobilen Landingpages : Der Analyse zufolge sind Desktop-Versionen einer Website durchschnittlich 30 Prozent länger als ihre mobilen Pendants.

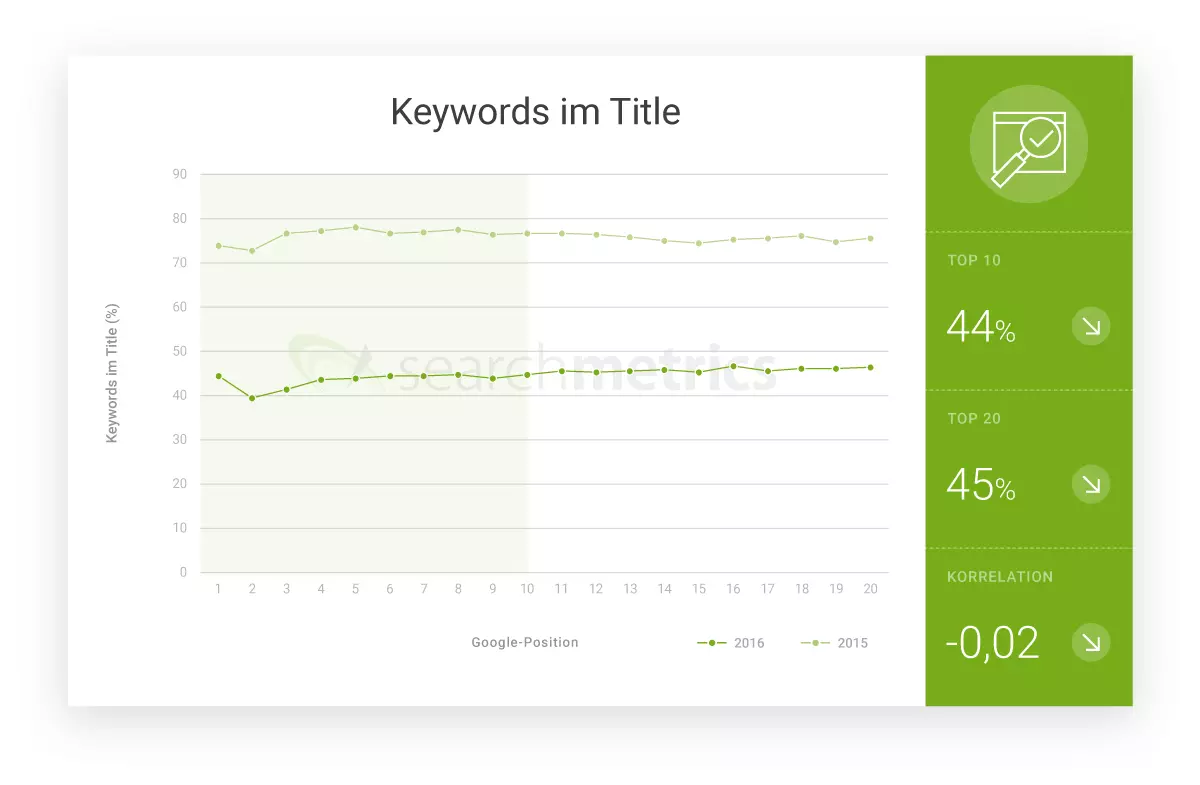

Das Keyword im Title verliert an Relevanz

Noch immer gilt in SEO-Abteilungen das Credo: Das Keyword im Title ist ein Muss – und es sollte am besten so weit vorne wie möglich platziert werden. Wie weit diese Annahme an der Realität in der Suchmaschine vorbeigeht, zeigt eine der zentralen Erkenntnisse der Searchmetrics-Studie:

„Nur 45 Prozent der Top-20-URLs hatten 2016 noch das Keyword im Title.“

Auch diese Entwicklung lässt sich mit dem holistischen Ansatz der Content-Erstellung erklären, bei dem Texte auf Themen und nicht auf Keywords optimiert werden. Googles KI-System ist inzwischen durchaus in der Lage, semantische Beziehungen auszuwerten, ohne dass Keywords die Richtung vorgeben.

In ähnlichem Umfang lässt sich diese Entwicklung auch bei Headlines und Descriptions beobachten. Laut Searchmetrics führt nur noch ein Drittel aller Top-20-Landingpages das Keyword in der Hauptüberschrift (H1).

Nutzersignale

Um zu bestimmen, ob Google-Nutzer mit den vorgeschlagenen URLs zufrieden sind, muss sich der Konzern nicht ausschließlich auf indirekte Faktoren wie die semantische Analyse von Webseiten-Inhalten verlassen. Neben der Suchmaschine liefern auch Google-Produkte wie der Webbrowser Chrome, das Webanalyse-Plug-in Analytics, das Werbesystem AdWords und das mobile Betriebssystem Android detaillierte Informationen über das Surfverhalten der Google-Nutzer.

Ob eine Webseite das bietet, was sie verspricht, kann Google über einschlägige Nutzersignale wie Klick- und Absprungraten sowie die durchschnittliche Verweildauer in Kombination mit einer gigantischen Datenbasis detailliert auswerten und im Rahmen von Methoden des maschinellen Lernens in Echtzeit auf das Suchmaschinen-Ranking anwenden. Auch hier gibt die Searchmetrics-Studie hilfreichen Input für Webseitenbetreiber und SEO-Berater.

Die durchschnittliche Klickrate auf den Positionen 1 bis 3 beträgt 36 Prozent

Das Vertrauen der Nutzer in die Relevanzbewertung der Suchmaschine ist groß. Darauf wies bereits die Searchmetrics-Studie aus dem Jahr 2014 hin, in der die durchschnittliche Klickrate (Click-Through-Rate, CTR) der analysierten Top-URLs ermittelt wurde.

Folglich verzeichnen Websites auf Position 1 die meisten Klicks. Für die Pole-Position hat das Searchmetrics-Team eine durchschnittliche CTR von 44 Prozent ermittelt. Diese nimmt über die Suchergebnispositionen hinweg ab. Bereits auf Position 3 liegt die CTR nur noch bei 29 Prozent.

„Die durchschnittliche CTR auf den Positionen 1–3 beträgt 36 Prozent.“

Auffällig ist ein deutlicher Anstieg der CTR für die Position 11. Die erste Landingpage auf der zweiten Suchergebnisseite bekommt im Durchschnitt mehr Klicks als Landingpages am Ende der ersten Suchergebnisseite.

Im Vergleich zu 2014 ist die durchschnittliche CTR der Top-10-URLs im Google-Ranking deutlich gestiegen.

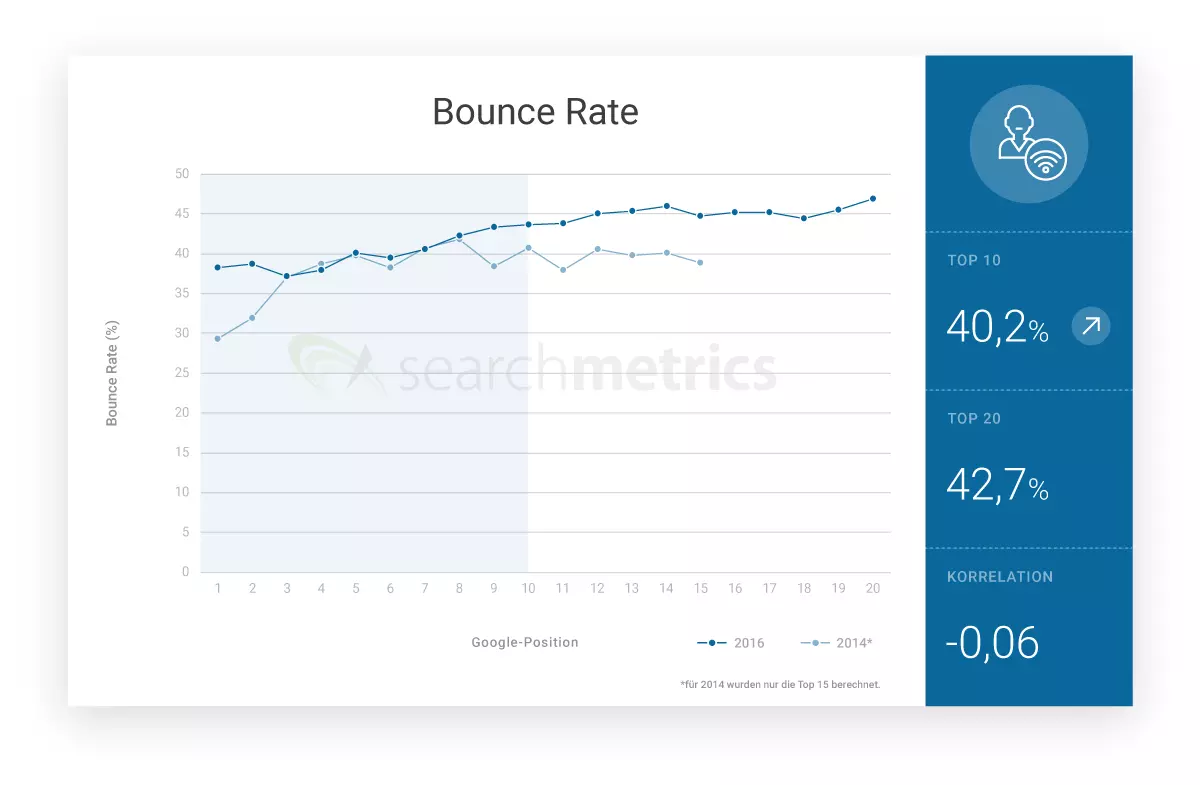

Die Absprungrate auf der ersten Suchergebnisseite steigt auf rund 40 Prozent

Interessant für die Relevanzbewertung einer Website ist neben der CTR die sogenannte Absprungrate (Bounce-Rate). Diese zeigt, wie viele Nutzer nach dem Klick auf ein Suchergebnis, direkt auf Google.de zurückkehren, ohne sich auf anderen URLs der besuchten Domain umzuschauen.

Für die untersuchten URLs ermittelte das Searchmetrics-Team mit durchschnittlich 40 Prozent einen leichten Anstieg der Bounce-Rate auf den Top-10-Positionen im Vergleich zum Jahr 2014. Eine deutliche Abweichung zeigt sich vor allem für die Top-Positionen 1 und 2.

Den Analysten zufolge kann von der ermittelten Bounce-Rate jedoch nur bedingt auf die Relevanz einer Website geschlossen werden. Der Absprung eines Nutzers hat immer individuelle Gründe und kann im Einzelfall auch dann erfolgen, wenn die Suchanfrage zufriedenstellend beantwortet wurde. Denkbar ist dies beispielsweise bei rein informationalen Suchanfragen, die sich bereits durch einfache Glossar- oder Lexikoneintrage beantworten lassen.

Als Erklärung für den ermittelten Anstieg der durchschnittlichen Bounce-Rate nennt das Searchmetrics-Team die hohe Qualität des Google-Algorithmus. Dank des neuen KI-Systems ist die Suchmaschine heute in der Lage, genau die URL auszuspielen, die der Suchintention des Nutzers am besten entspricht. Dieser muss dadurch immer seltener mehrere URLs einer Domain aufrufen, um die gewünschten Informationen zu finden.

Die durchschnittliche Verweildauer steigt

Spannend für die Relevanzbewertung einer Website ist vor allem die Zeit zwischen Klick und Absprung. Die Time on Site, also die Verweildauer eines Nutzers auf der über die Websuche angesteuerten Seite, lässt sich dank Webanalytics präzise messen. Auch hier präsentiert uns Searchmetrics einen Durchschnittswert, der differenziert betrachtet werden muss.

„Die Time On Site für Top-10-URLs liegt bei 3 Minuten und 43 Sekunden.“

Vergleicht man den Wert der aktuellen Studie mit dem aus 2014, lässt sich ein deutlicher Anstieg der Verweildauer für die Top-10-URLs erkennen. Diese Entwicklung lässt sich darauf zurückführen, dass Webseitenbetreiber, die bei Google gut ranken möchten, dazu übergegangen sind, Besuchern höherwertigen Content zur Verfügung zu stellen.

Auch wenn eine hohe Verweildauer auf hochwertige Webinhalte hinweist, bedeutet dies im Umkehrschluss nicht, dass eine geringe Verweildauer automatisch auf eine schlechte Landingpage schließen lässt. Beispielsweise kann eine Website der Suchintention eines Nutzers, der lediglich den aktuellen Wetterbericht oder die Fußballergebnisse vom letzten Wochenende sucht, vergleichsweise schnell gerecht werden.

Technische Faktoren und Usability

Die Erstellung hochwertiger Mehrwert-Inhalte ist nur eine Säule der Suchmaschinenoptimierung. Auch der beste Content wird die Top-Positionen im Google-Ranking nicht erreichen, wenn die technischen Grundvoraussetzungen fehlen. Zeitgemäße Webseiten müssen sich an Faktoren wie Performance, Sicherheit und Usability messen lassen. Bei der technischen Bereitstellung von Webinhalten zeichneten sich 2016 neben allgemeinen Faktoren wie der Seitenladezeit und Dateigröße vor allem zwei SEO-Trends ab: Immer mehr Webseitenbetreiber bemühen sich darum, ihren Besuchern Inhalte mobil zur Verfügung zu stellen. Zudem unterstreicht Searchmetrics die Bedeutung einer Transportverschlüsselung via HTTPS für das Suchmaschinen-Ranking.

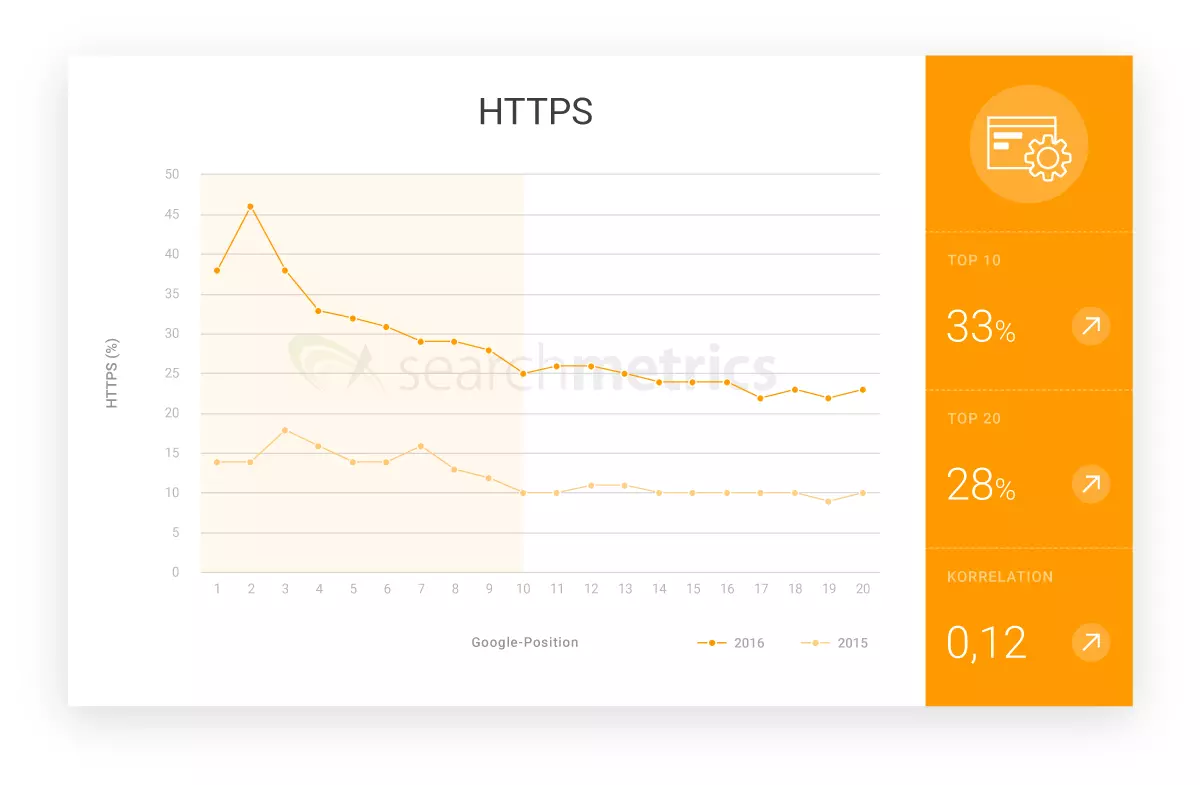

HTTPS wird 2017 zum Muss

Webmaster, die auch 2017 auf eine Transportverschlüsselung via HTTPS verzichten, dürften es bald schwer haben, in den Suchmaschinenrankings aufzusteigen. Bereits im September 2016 kündigte Google an, HTTP-Seiten, auf denen sensible Daten verarbeitet werden, ab 2017 als unsicher zu markieren. Man muss kein SEO-Experte sein, um sich auszumalen, wie solch digitales Brandmal auf die Klickbereitschaft der Google-Nutzer wirken wird. Nicht zuletzt aus diesem Grund nimmt die Zahl HTTPS-verschlüsselter Webseiten stetig zu. Lag der Anteil der Top-10-Landingpages, die auf HTTPS setzen, im Vorjahr noch bei 14 Prozent, konnte Searchmetrics in der aktuellen Studie einen deutlichen Anstieg auf 33 Prozent feststellen. „Ein Drittel der Landingpages in den Top 10 setzt inzwischen auf HTTPS-Verschlüsselung."

Mobilfreundlichkeit wird Grundvoraussetzung für ein gutes Ranking

Suchanfragen aus dem mobilen Netz nehmen konstant zu. Laut einem Google-Bericht aus dem Jahr 2015 verzeichnet der Suchmaschinen-Marktführer in relevanten Märkten wie den USA und Japan mittlerweile mehr Anfragen von Mobilgeräten als von Desktop-Computern. Welche Bedeutung der Faktor Mobilfreundlichkeit künftig für ein Ranking in der Suchmaschine haben wird, zeigt Googles Mobile-First-Strategie. Im Oktober 2016 kündigte das Unternehmen an, den Mobile-Index künftig als Hauptindex für die Websuche zu verwenden. Es ist somit anzunehmen, dass sich dieser auch auf das Ranking in der Desktop-Websuche auswirken wird. Für Webmaster, die mobile Nutzer noch immer vernachlässigen, sollte eine entsprechende Umgestaltung des Webangebots für das Jahr 2017 ganz oben auf der Agenda stehen. Möglichkeiten zur Bereitstellung mobilfreundlicher Websites bilden Mobile Subdomains, ein Responsive Webdesign sowie die dynamische Ausspielung von Inhalten.

Social Signals

Wie schon 2014 zeigt die Searchmetrics-Studie auch 2016 eine hohe Korrelationen zwischen einem Top-Rating in der Suchmaschine und sogenannten Social Signals. Dabei handelt es sich um kommunikative Signale wie Shares, Likes und Kommentare in sozialen Netzwerken wie Facebook, Twitter, Pinterest oder Google+. Ein gutes Google-Ranking mit der Social-Media-Präsenz in einen kausalen Zusammenhang zu bringen, fällt den Analysten jedoch nach wie vor schwer.

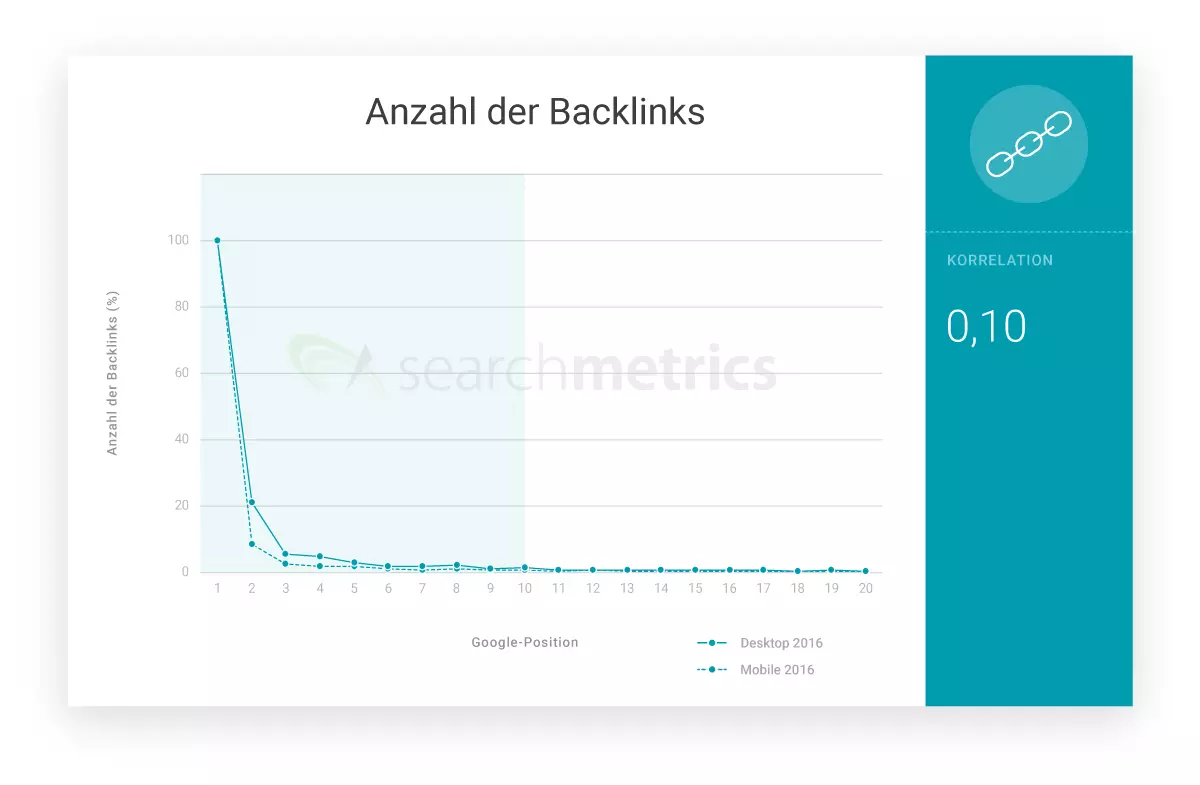

Backlinks

Auch die Anzahl der Backlinks einer Website korreliert weiterhin mit ihrer Platzierung in der Suchmaschine. Im Rahmen der Suchmaschinenoptimierung rückt der Linkaufbau jedoch zunehmend in den Hintergrund. Laut Searchmetrics ist das Backlinkprofil einer Website längst nicht mehr der entscheidende Faktor für den Erfolg bei Google, sondern nur noch einer von vielen.

Google ist heute mehr denn je in der Lage, den Mehrwert einer Webseite anhand semantischer Zusammenhänge und direkter Nutzersignale zu evaluieren. Das Backlinkprofil als Qualitätsmerkmal wird von der Content-Relevanz abgelöst. Standen eingehende Verweise von repräsentativen Webseiten lange Zeit hoch im Kurs, werden sich Webmaster künftig fragen müssen, inwieweit die inhaltlichen Angebote ihrer Landingpages die Erwartungen der Nutzer erfüllen.

Dass Backlinks künftig gänzlich aus dem Google-Algorithmus verschwinden, ist zunächst jedoch nicht zu befürchten. Dies bestätigen auch die Ergebnisse der Searchmetrics-Studie. Ausschließlich backlinkorientierte Suchmaschinenoptimierung ist jedoch ein Auslaufmodell.

„Die Korrelationen für Backlinks sind weiterhin hoch, deren Bedeutung fürs Ranking wird jedoch weiter abnehmen."

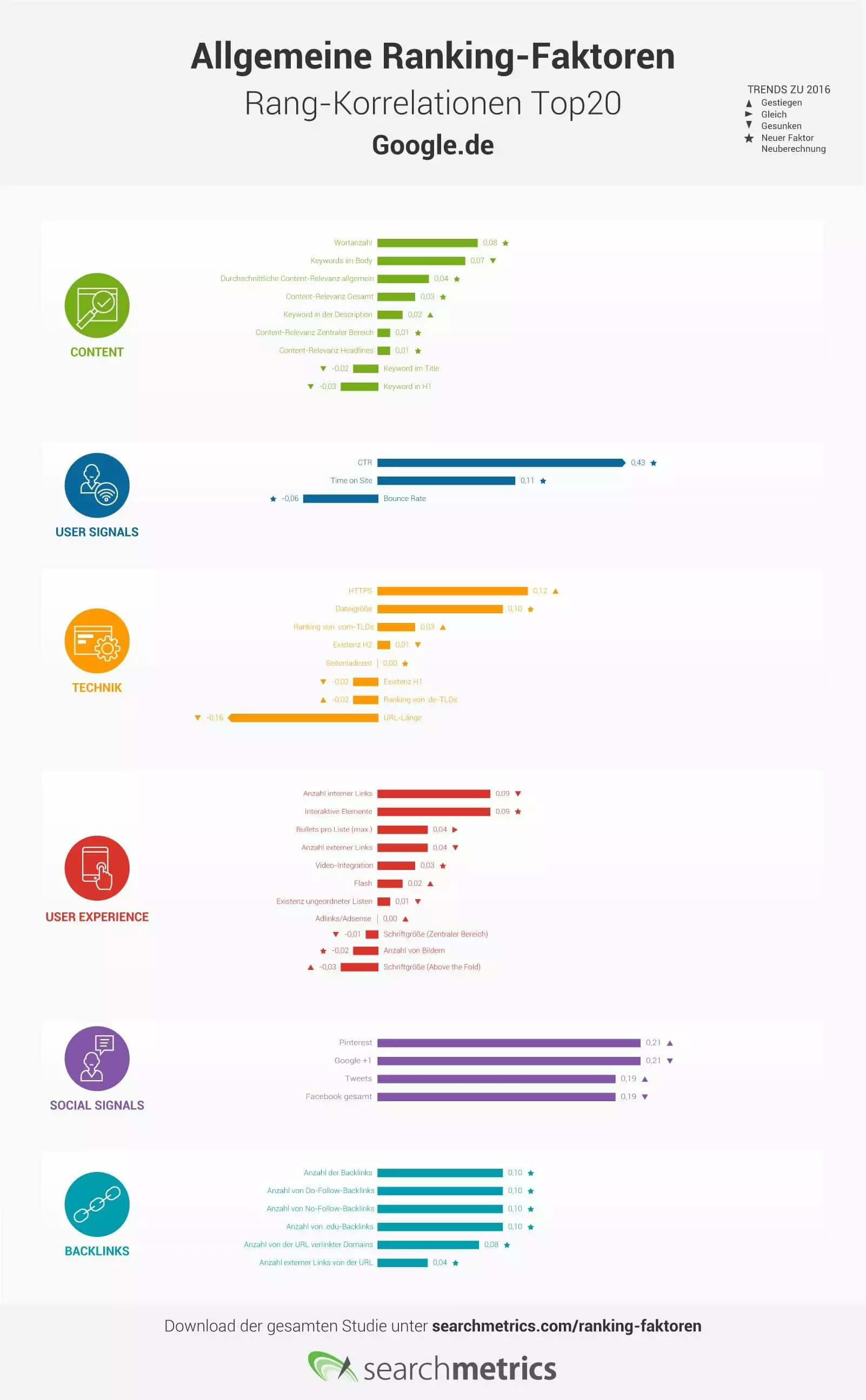

Ranking-Faktoren in Korrelation zum Suchmaschinen-Rang

Die nachfolgende Grafik zeigt die Rang-Korrelation allgemeiner Ranking-Faktoren für die von Searchmetrics untersuchten Top-20-URLs sowie die Entwicklung im Vergleich zum Vorjahr. Ranking-Faktoren, zu denen 2016 erstmalig Daten erhoben wurden sowie neuberechnete Faktoren sind mit einem Stern gekennzeichnet.

Klicken Sie hier, um die Infografik zu den Rang-Korrelationen allgemeiner Ranking-Faktoren herunterzuladen.

Fazit: Die Zukunft der Suchmaschinenoptimierung

Die Searchmetrics-Studie „Rebooting Ranking-Faktoren Google.de“ zeigt: Nach wie vor gibt es Faktoren, die mit einem guten Google-Ranking korrelieren. Diese lassen sich jedoch nicht mehr pauschal auf jede Website übertragen. Die unterschiedlichen Ansprüche, die Mensch und Maschine an Webseiten aus verschiedenen Branchen stellen, lassen sich mit allgemeinen Ranking-Faktoren nur noch unzureichend abbilden.

Zeitgleich mit der Veröffentlichung der aktuellen Analyse kündigt das Searchmetrics-Team daher differenziertere Folgestudien an, die die Bedürfnisse einzelner Industriezweige gesondert unter die Lupe nehmen sollen. Auch die alljährliche Studie zu Ranking-Faktoren und Rang-Korrelationen wird sich künftig auf branchenspezifische Keyword-Sets (z. B. für die Märkte E-Commerce, Gesundheit, Finanzen etc.) stützen. Die Searchmetrics-Studie 2016 liest sich somit auch als Mahnung an Webmaster, simples Checklisten-SEO ein für alle Mal abzuhaken und Trends und Prognosen im Bereich der Suchmaschinenoptimierung branchenspezifisch zu interpretieren.