RankBrain: Die Evolution des Google-Algorithmus

Google setzt im Rahmen der Websuche auf eine selbstlernende Algorithmus-Komponente. Mit dieser Nachricht sorgte Senior Research Scientist Greg Corrado am 15. Oktober 2015 für Aufsehen. Der Agentur Bloomberg gegenüber gab der Google-Mitarbeiter bekannt, dass sich der Suchmaschinenmarktführer bei der Interpretation von Nutzeranfragen auf künstliche Intelligenz (KI) stützt. Ein entsprechendes System namens „RankBrain“ sei bereits Monate vor der Veröffentlichung des Interviews in den Algorithmus der Suchmaschine integriert worden.

Seit Jahren investiert Google Millionen in die KI-Forschung. Bereits 2012 heuerte der Suchmaschinenanbieter den Technikvisionär Raymond Kurzweil an. 2014 folgte die Übernahme des auf KI-Systeme spezialisierten Start-ups DeepMind für rund 500 Millionen Euro. Mit RankBrain fließen Googles Bemühungen auf dem Gebiet der KI-Forschung nun auch ins Kerngeschäft des Unternehmens ein. Doch wie schlau ist die neue Technologie wirklich? Und welche Auswirkungen hat RankBrain auf die Arbeit von Webseitenbetreibern und SEO-Experten?

Was ist RankBrain?

Corrado zufolge kommt RankBrain seit Anfang 2015 als Teil des übergeordneten Google-Suchalgorithmus „Hummingbird“ zum Einsatz – zuerst noch mit Beschränkung auf neue Suchanfragen.

Eigenen Angaben zufolge nimmt Google täglich rund 3 Milliarden Anfragen über die Websuche entgegen. Bei rund 15 Prozent der Nutzereingaben handelt es sich um Keywords und Wortkombinationen, die in der jeweiligen Form noch nie zuvor bei Google eingegangen sind – darunter umgangssprachliche Begriff, Wortneuschöpfungen oder komplexe Longtail-Phrasen.

Bei einem Longtail-Keyword (Keyword mit „langem Schwanz“) handelt es sich um einen komplexen Suchbegriff, der aus mehreren Wörtern bis hin zu einem kompletten Satz besteht. Das Gegenteil zu Longtail ist Shorthead, also kurze prägnante Suchphrasen. Zum Vergleich: wie funktioniert ein cloud-server vs. cloud-server.

2016 wurde der Einsatz von RankBrain auf die gesamte Google-Suche ausgeweitet, sodass die Technologie heute in die Bearbeitung aller Anfragen involviert ist, die Google über die Websuche entgegennimmt.

Hauptaufgabe von RankBrain ist die Interpretation von Keywords und Suchphrasen mit dem Ziel, die jeweilige Nutzerintention zu ermitteln. Im Rahmen des Bloomberg-Artikels wurde RankBrain als selbstlernendendes KI-System vorgestellt. Doch was versteht Google unter künstlicher Intelligenz? Und wie funktioniert RankBrain genau?

Machine Learning: Making Sense of a Messy World (Google via YouTube).

KI-Forschung: 60 Jahre künstliche Intelligenz

Fest steht, ein völlig autonom denkender Computer und die von Futuristen prognostizierte technologische Singularität sind nach wie vor Science-Fiction. Stattdessen beschäftigt sich die KI-Forschung seit rund 60 Jahren mit der Automatisierung intelligenten Verhaltens. Eine allgemeingültige Definition des Begriffs „künstliche Intelligenz“ sucht man bis heute vergeblich. Gleiches gilt für den Intelligenz-Begriff an sich.

Als Geburtsstunde der KI-Forschung gilt eine Konferenz am US-amerikanischen Dartmouth College im Jahr 1956. Das Themenspektrum der Veranstaltung umfasste laut Förderantrag von 1955 automatische Computer, Sprachsynthese, Neuronale Netzwerke, Maschinelles Lernen sowie Betrachtungen zu Abstraktion, Zufall und Kreativität. All dies fasste John McCarthy – Hauptverantwortlicher für die Organisation – unter dem bis dahin unbekannten Schlagwort Artificial Intelligence („Künstliche Intelligenz“) zusammen. Damit legte der mehrfach ausgezeichnete Informatiker den Grundstein für ein neues interdisziplinäres Fachgebiet, dessen Forschungsinteresse er im Förderantrag zur Dartmouth Conference folgendermaßen definierte:

For the present purpose the artificial intelligence problem is taken to be that of making a machine behave in ways that would be called intelligent if a human were so behaving.

John McCarthy, 1955

Eine ähnliche Definition findet sich bis heute in der Encyclopaedia Britannica:

Artificial intelligence (AI), the ability of a digital computer or computer-controlled robot to perform tasks commonly associated with intelligent beings.

Encyclopaedia Britannica

Einen Versuchsaufbau, um die Intelligenz einer Maschine objektiv auf die Probe zu stellen, schlug Computerpionier Alan Turing bereits im Jahr 1950 vor. Im sogenannten Turing-Test führt ein menschlicher Proband über Tastatur und Bildschirm und somit ohne Sicht- und Hörkontakt eine Unterhaltung mit zwei ihm unbekannten Gesprächspartnern: der eine ein Mensch, der andere eine Maschine. Ziel beider Gesprächspartner ist es, den Probanden davon zu überzeugen, dass er es mit einem denkenden Wesen zu tun hat. Laut Turing hat eine Maschine den Test bestanden, wenn der Proband trotz eingehender Befragung nicht klar sagen kann, bei welchem Gesprächspartner es sich um die Maschine handelt. Bis heute gilt der Turing-Test als unüberwindbare Hürde. Große mediale Aufmerksamkeit bekam in diesem Zusammenhang der Chatbot Eugene Goostman. Dieser stellte sich dem Test im Jahr 2014 in einem abweichenden Versuchsaufbau. Der Erfolg des Supercomputers wird von Experten daher bestritten. Kritiker bezweifeln indes, dass der von Turing entwickelte Test überhaupt geeignet ist, maschinelle Intelligenz zu beweisen. Schließlich simuliere der Versuchsaufbau lediglich eine zwischenmenschliche Unterhaltung. Die Sprachfähigkeit spiegle jedoch nur einen Teilbereich der menschlichen Intelligenz wider. Zudem überprüfe der Turing-Test ausschließlich, ob sich die von einer Maschine ausgehenden Signale als intelligentes Verhalten deuten lassen. Nach dem Vorhandensein von Intelligenz – beispielweise in Form von Intentionalität oder Bewusstsein – werde nicht gefragt. In der praktischen Anwendung ist diese Unterscheidung jedoch von zweitrangiger Bedeutung. Hier steht vor allem die Funktionalität von KI-Systemen im Vordergrund. Diese praxisnahe Herangehensweise an die KI-Forschung zeigt sich in der Definition der Informatikerin Elaine Rich:

Artificial Intelligence is the study of how to make computers do things at which, at the moment, people are better.

Elaine Rich, 1983

Es gibt somit zwei unterschiedliche Begriffe künstlicher Intelligenz:

- Starker KI-Begriff (Strong Artificial Intelligence): Gemäß des starken KI-Begriffs müsste eine Maschine dem Menschen ähnliche intellektuelle Fähigkeiten besitzen, um als intelligent zu gelten. Neben der Fähigkeit, Schlussfolgerungen zu ziehen und Probleme zu lösen, umfasst dieser Begriff Konzepte wie Bewusstsein, Selbsterkenntnis, Eigenwahrnehmung, Empfindungsvermögen und Weisheit. Ziel ist es, Intelligenz zu erschaffen.

- Schwacher KI-Begriff (Weak Artificial Intelligence): Gemäß des schwachen KI-Begriffs genügt es, Maschinen mit Fähigkeiten auszustatten, die beim Menschen mit intelligentem Verhalten assoziiert werden. Ziel ist es somit, intelligentes menschliches Verhalten wie logisches Denken, das Treffen von Entscheidungen, Planen, Lernen und Kommunikation mithilfe mathematischer Regeln zu simulieren.

Wenn Google in Bezug auf RankBrain von einem selbstlernenden KI-System spricht, ist damit künstliche Intelligenz gemäß des schwachen KI-Begriffs gemeint. Es handelt sich um eine Technologie, die für Problemstellungen, die bisher von Menschen bearbeitet werden mussten, automatische Lösungen findet. Wie die meisten Systeme dieser Art greift auch RankBrain dabei auf Techniken des maschinellen Lernens zurück.

Unter maschinellem Lernen (engl. machine learning) versteht man die künstliche Generierung von Wissen aus Erfahrung. Machine-Learning-Systeme analysieren große Datenmengen, identifizieren mithilfe mathematischer Algorithmen Muster, Trends und Querverbindungen und gelangen auf Grundlage dieser Daten zu selbstständigen Vorhersagen.

Bei RankBrain handelt es sich per Definition um künstliche Intelligenz gemäß des schwachen KI-Begriffs. Das System stützt sich auf Techniken des maschinellen Lernens und kommt im Rahmen des Google-Suchalgorithmus bei der Interpretation von Nutzereingaben zum Einsatz.

Wie funktioniert RankBrain?

RankBrain hilft Google, Nutzereingaben zu interpretieren und so genau die Webseiten aus dem Google-Suchindex – einer rund 100 Millionen Gigabyte großen Datenbank – herauszusuchen, die am besten zur Suchintention des Nutzers passen. Dabei geht das KI-System weit über den reinen Abgleich von Suchbegriffen hinaus.

Bereits mit dem Hummingbird-Update im August 2013 hat Google die sogenannte semantische Suche implementiert. Während Suchbegriffe und Wortkombinationen vor Hummingbird statisch und ohne Sinnzusammenhang bewertet wurden, rückte mit dem Update des Google-Algorithmus die Bedeutung der Nutzereingabe im Gesamten in den Mittelpunkt. Mit RankBrain ergänzt Google die semantische Suche nun um ein selbstlernendes KI-System, das in der Lage ist, im Vorfeld erworbenes Wissen zur Beantwortung neuer und einzigartiger Suchanfragen heranzuziehen.

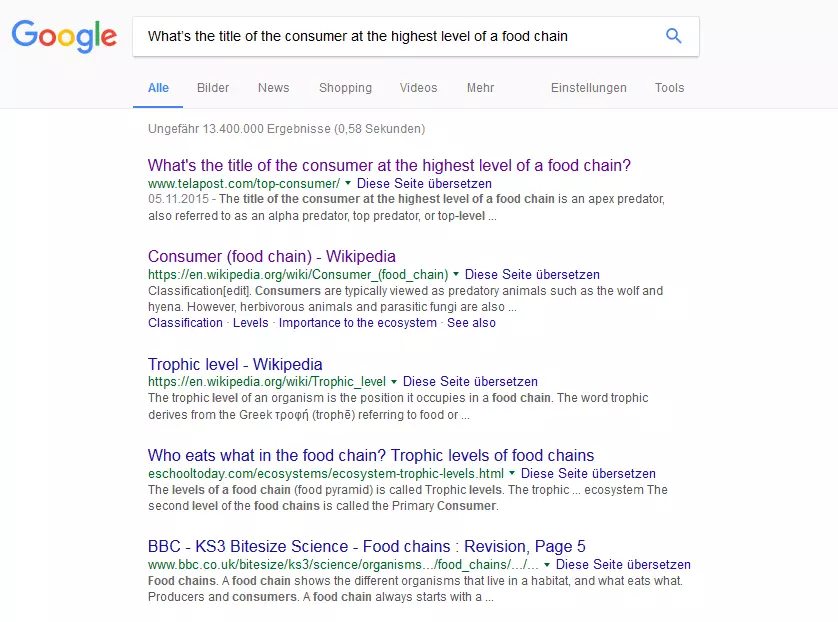

Bloomberg gegenüber gibt Google folgende Suchanfrage als Anwendungsbeispiel für RankBrain:

„What’s the title of the consumer at the highest level of a food chain“

Statt jedes einzelne Wort der Frage unabhängig voneinander zu analysieren, erfasst RankBrain die Semantik der gesamten Nutzereingabe und ermittelt so die Intention des Suchenden. Trotz Longtail-Phrase gelangt ein Suchender so blitzschnell zur erhofften Antwort.

Als Machine-Learning-System greift RankBrain dabei auf seine Erfahrung mit vorhergehenden Suchanfragen zurück, stellt Verknüpfungen her und trifft darauf aufbauend Vorhersagen darüber, was der jeweilige Nutzer sucht und wie dessen Anfrage am besten zu beantworten ist. Dabei gilt es, Ambiguitäten aufzulösen und die Bedeutung bisher unbekannter Begriffe (z. B. Neologismen) zu erschließen. Wie das KI-System diese Herausforderung meistert, verrät Google allerdings nicht. SEO-Experten vermuten jedoch, dass RankBrain Suchanfragen mithilfe von Wortvektoren in eine Form überträgt, die es Computern ermöglicht, Sinnzusammenhänge zu interpretieren. Bereit 2013 hat Google die quelloffene Machine-Learning-Software Word2Vec veröffentlicht, mit der sich semantische Beziehungen zwischen Wörtern in eine mathematische Darstellung überführen, messen und vergleichen lassen. Grundlage dieser Analyse sind linguistische Textkorpora. Um Sinnzusammenhänge zwischen Wörtern zu „lernen“, erzeugt Word2Vec im ersten Schritt einen n-dimensionalen Vektorraum, in dem jedes Wort des zugrundeliegenden Textkorpus (man spricht von „Trainingsdaten“) als Vektor repräsentiert ist. Dabei gibt n an, in wie vielen Vektordimensionen ein Wort abgebildet werden soll. Je mehr Dimensionen für die Wortvektoren gewählt werden, desto mehr Relationen zu anderen Wörtern erfasst das Programm. Im zweiten Schritt wird der erstellte Vektorraum in ein künstliches neuronales Netz (KNN) eingespeist, das es ermöglicht, diesen mithilfe eines Lernalgorithmus so anzupassen, dass Wörter, die im gleichen Kontext verwendet werden, auch einen ähnlichen Wortvektor bilden. Die Ähnlichkeit zwischen Wortvektoren wird anhand der sogenannten Kosinus-Distanz als Wert zwischen -1 und +1 berechnet. Kurz gesagt: Gibt man Word2Vec einen beliebigen Textkorpus als Input, liefert das Programm entsprechende Wortvektoren als Output. Diese ermöglichen eine Beurteilung der semantischen Nähe bzw. Distanz der im Korpus enthaltenen Wörter. Wird Word2Vec mit neuem Input konfrontiert, ist das Programm dank des Lernalgorithmus in der Lage, den Vektorraum anzupassen und somit neue Bedeutungszusammenhänge herzustellen oder alte Annahmen zu verwerfen: Das neuronale Netz wird „trainiert“.

Mithilfe künstlicher neuronaler Netze (KNN) versuchen KI-Forscher die Organisations- und Verarbeitungsprinzipien des menschlichen Gehirns zu simulieren. Ziel ist es, Systeme zu entwickeln, die in der Lage sind, bei der Lösung von Problemen mit Vagheit oder Unschärfe umzugehen und somit auch Aufgaben zu übernehmen, die bisher dem Menschen vorbehalten waren. Zur Anwendung kommen neuronale Netze bei Google beispielsweise im Rahmen der automatischen Bilderkennung.

Offiziell stellt Google keinen Zusammenhang zwischen der Funktionsweise von Word2Vec und der Suchalgorithmus-Komponente RankBrain her, es ist jedoch anzunehmen, dass sich das KI-System auf ähnliche mathematische Operationen stützt.

RankBrain und Suchmaschinenoptimierung (SEO)

Überraschender noch als die Bekanntgabe, dass Googles Forschungsergebnisse im Bereich künstlicher Intelligenz in die Websuche einfließen, ist der Umfang, in dem dies geschieht: Nicht nur, dass Google seit 2016 sämtliche Suchanfragen von RankBrain interpretieren lässt; Corrado zufolge ist das selbstlernende KI-System sogar als drittwichtigster Ranking-Faktor in den Google-Algorithmus eingebunden.

Laut Google fungiert RankBrain als drittwichtigster Ranking-Faktor im Rahmen der Websuche. Platz 1 und 2 teilen sich laut Google Search Quality Senior Strategist Andrey Lipattsev.

Für Webseitenbetreiber und SEO-Experten ändert sich damit vor allem der Blick auf Keyword-Strategien. Als semantische Suchmaschine ist Google in der Lage, auf Hintergrundwissen in Form von Konzepten und Beziehungen zurückzugreifen, um die inhaltliche Bedeutung von Texten und Suchanfragen zu ermitteln.

Ob eine Webseite für einen bestimmten Suchbegriff gut rankt, hängt damit weniger davon ab, ob diese den Suchbegriff enthält, als vielmehr davon, ob der (Text-)Inhalt der Webseite für das jeweilige Konzept relevant ist, das RankBrain mit dem Suchbegriff verbindet. Im Fokus steht somit nicht das Keyword an sich, sondern die Content-Relevanz einer Webseite.

Zu diesem Ergebnis kam auch das Software-Unternehmen Searchmetrics, das auf dem internationalen SEO-Markt mit einer Search- und Content-Marketing-Plattform präsent ist und seit 2012 eine vielbeachtete Studienreihe zu den zentralen Ranking-Faktoren des Google-Algorithmus herausgibt.

Klassisches Checklisten-SEO hat ausgedient, so die Kernaussage der Studie von 2016. Unter dem Titel „Rebooting Ranking-Faktoren Google.de“ geht Searchmetrics auf die jüngsten Entwicklungen bei Google ein. Das Fazit: Allgemeingültige Ranking-Faktoren werden dem aktuellen Entwicklungsstand der Suchmaschine nicht mehr gerecht. Stattdessen sollten sich Webseitenbetreiber auf Content-Relevanz und Nutzerfokus konzentrieren. Welche Ansprüche ein Nutzer an eine Webseite stellt, unterscheidet sich je nach Bereich und Branche jedoch deutlich. Das Unternehmen kündigt daher an, zukünftig branchenspezifische Untersuchungsergebnisse zu präsentieren.

Dank RankBrain rücken Content-Relevanz und Nutzerintention in den Fokus der Suchmaschinenoptimierung.

Um den Zusammenhang zwischen dem Ranking einer Webseite und deren Relevanz für den jeweiligen Suchbegriff zu untersuchen, bediente sich Searchmetrics in der Studie von 2016 ebenfalls einer Word-Embedding-Software, die semantische Beziehungen in Form von Vektoren darstellt. Ausgehend von einem Set von 10.000 Keywords ermittelte das Unternehmen für jeden Suchbegriff die Content-Relevanz der ersten 20 Suchergebnisse unter Ausblendung des Keywords. Dazu strichen die Analysten den jeweiligen Suchbegriff aus den Texten der rankenden Webseiten und ermittelten für den übrigen Inhalt einen Relevanz-Score von 0 bis 100. Dieser wurde anschließend mit der Position auf den Suchergebnisseiten in Beziehung gesetzt.

Das Ergebnis: Webseiten auf den vorderen Google-Positionen zeichneten sich durch eine deutlich höhere Content-Relevanz aus als Seiten, die in der Suchmaschine schlechter abschnitten. Die höchste Content-Relevanz ermittelte Searchmetrics für Webseiten auf den Positionen 3 bis 6. Hier ist zu beachten, dass die Positionen 1 und 2 bei vielen Suchbegriffen von Unternehmensseiten besetzt werden, die laut Searchmetrics beim Google-Ranking zusätzlich von einem Brand-Faktor profitieren.

Auch die besten Inhalte erklimmen die Spitze des Google-Rankings nur dann, wenn die technische Grundlage gegeben ist. Erfolgreiche Seiten sind für Mensch und Maschine gleichermaßen gut zugänglich. Zentrale Faktoren sind neben Seitenladezeit und Dateigröße die URL-Struktur einer Website sowie deren interne Verlinkung. Seit Googles Mobile-Friendly-Update gehören zudem für mobile Geräte optimierte Inhalte und Seitenarchitektur zu den technischen Grundvoraussetzungen des Webseitenerfolgs.

Es bleibt die Frage: Wie sollten Webseitenbetreiber auf RankBrain und andere Entwicklungen bei Google reagieren? Als einen zentralen Erfolgsfaktor nennt Searchmetrics eine holistische Textgestaltung. Gemeint ist damit eine Texterstellung, die sich nicht an Keywords, sondern an Themen orientiert. Im Fokus steht dabei der Nutzer. Ziel ist es, Suchanfragen bei Google mit relevanten Inhalten zu beantworten. Dazu sollten Webseitenbetreiber für alle Keywords, auf die sie ranken möchten, die Suchintention ermitteln. Nur so lassen sich Suchbegriffe strukturieren und zu Themenfeldern zusammenführen, die als Grundlage für einen Redaktionsplan und die Erstellung lesenswerter, inhaltsreicher Texte dienen.

Mehr über den Umgang mit Suchbegriffen erfahren Sie in unserer Ratgeberreihe zum Themenkomplex Keyword-Recherche, -Analyse und -Strategie.