Edge Computing

Im allgegenwärtigen Internet of Things (IoT) generieren Geräte kontinuierlichen Daten-Output, der gespeichert und bei kritischen Anwendungen in Echtzeit ausgewertet werden muss. Edge-Computing wertet diese Daten direkt an der Quelle aus und läutet somit einen Paradigmenwechseln im Zeitalter des Cloud-Computings ein.

Was ist Edge-Computing? Eine Definition

Bei Edge-Computing handelt es sich um einen Designansatz für IoT-Umgebungen, bei dem IT-Ressourcen wie Speicherkapazität und Rechenleitung möglichst nah an den datengenerierenden Endgeräten und Sensoren bereitgestellt werden. Damit bildet das Konzept eine Alternative zu klassischen Cloud-Lösungen mit zentralen Servern.

Der Begriff „edge“ leitet sich vom englischen Wort für Ecke, Kante oder Rand ab. Eine Anspielung darauf, dass die Datenverarbeitung bei diesem Ansatz nicht zentral in der Cloud, sondern dezentral am Rand des Netzwerks erfolgt. Damit soll Edge-Computing das bereitstellen, was die Cloud bisher nicht bietet: Server, die Massendaten aus intelligenten Fabriken, Versorgungsnetzen oder Verkehrssystemen ohne Zeitverzögerung auswerten können und bei Vorfällen unverzüglich Maßnahmen einleiten.

Grundbegriffe des Edge-Computings im Überblick

Beim Edge-Computing kommen etablierte Technologien in kompakter Bauweise unter neuem Namen zum Einsatz. Wir liefern Ihnen einen Überblick über die wichtigsten Grundbegriffe des Edge-Computings.

-

Edge: Als „Edge“ bezeichnet man im IT-Jargon den Rand des Netzwerks. Welche Komponenten dem Netzwerkrand zugeordnet werden, ist allerdings situationsabhängig. In Telekommunikationsnetzen beispielsweise kann ein Mobiltelefon den Rand des Netzwerks darstellen; in einem System vernetzter, autonom fahrender Autos das einzelne Fahrzeug.

-

Edge-Device: Als Edge-Device fungiert jedes datengenerierende Gerät am Rand des Netzwerks. Mögliche Datenquellen sind Sensoren, Maschinen, Fahrzeuge oder intelligente Geräte im Rahmen einer IoT-Umgebung – wie beispielsweise Waschmaschinen, Feuermelder, Glühbirnen oder Heizkörperthermostate.

-

Edge-Gateway: Bei einem Edge-Gateway handelt es sich um eine Recheninstanz am Übergang zwischen zwei Netzwerken. In IoT-Umgebungen kommen Edge-Gateways als Knotenpunkte zwischen dem Internet of Things und einem Kernnetz zum Einsatz.

Edge-Computing vs. Fog-Computing

Der Ansatz, die Cloud um lokale Recheninstanzen zu erweitern, ist nicht neu. Bereits 2014 etablierte der US-amerikanische Technologiekonzern Cisco den Marketing-Begriff Fog-Computing. In IoT-Umgebungen generierte Daten gelangen hierbei nicht mehr direkt in die Cloud, sondern werden zunächst in kleinen Rechenzentren zusammengeführt, ausgewertet und für weitere Verarbeitungsschritte selektiert.

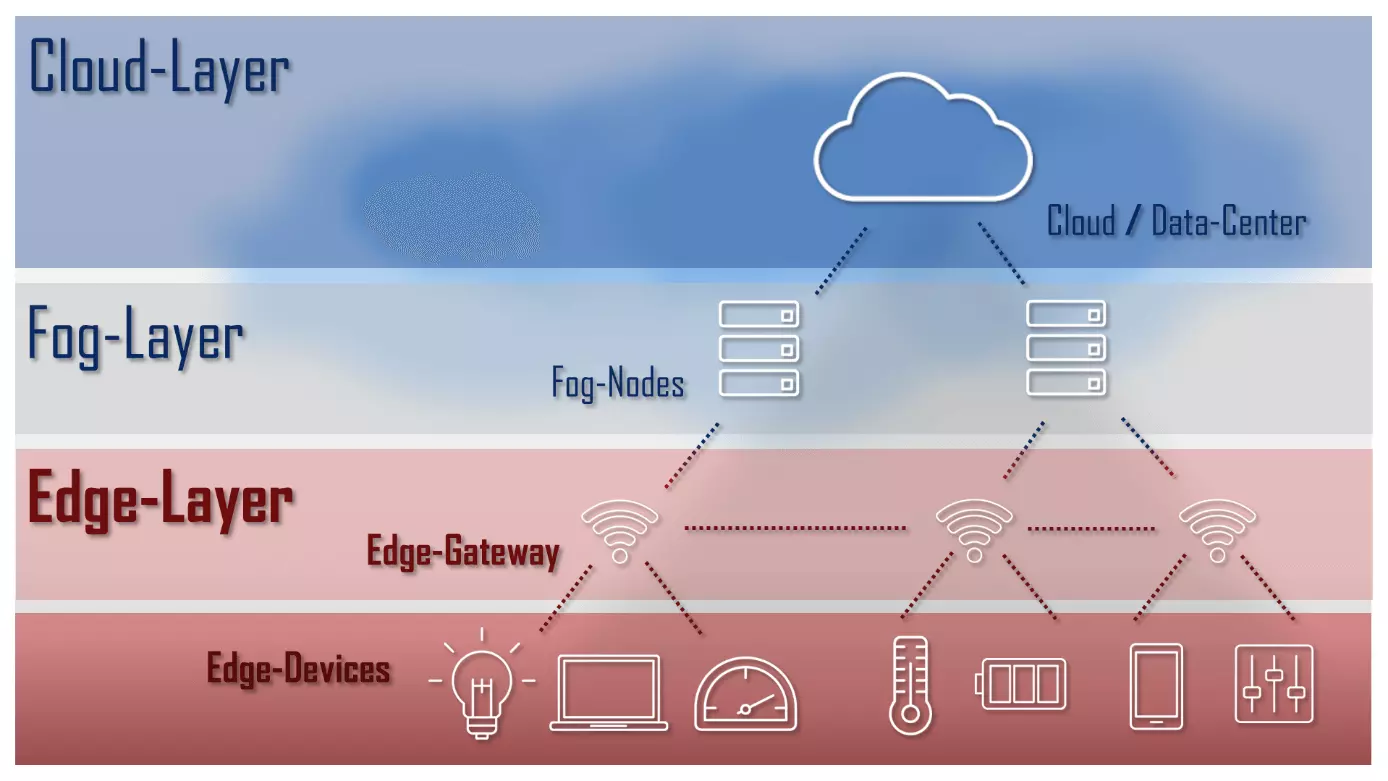

Edge-Computing wird heute als Teilbereich des Fog-Computings verstanden, bei dem IT-Ressourcen wie Rechenleistung und Speicherkapazität noch näher an die IoT-Endgeräte am Netzwerkrand heranrücken. Denkbar ist zudem eine Kombination beider Konzepte. Folgende Grafik zeigt eine solche Architektur mit Cloud-, Fog- und Edge-Layer:

Referenz-Architekturen für Fog- und Edge-Computing-Umgebungen werden im Rahmen des Open Fog Consortiums entwickelt, einem offenen Zusammenschluss von Industrie und Wissenschaft.

Was spricht für Edge-Computing?

Aktuell tragen zentrale Rechenzentren den Großteil der Datenlast, die das Internet generiert. Die Datenquellen sind heute jedoch häufig mobil und vom zentralen Großrechner zu weit entfernt, um eine akzeptable Reaktionszeit (Latenz) zu gewährleisten. Problematisch wird dies insbesondere bei zeitkritischen Anwendungen wie maschinellem Lernen und Predictive Maintenance – zwei grundlegenden Konzepten des Zukunftsprojekts Industrie 4.0.

Predictive Maintenance – die vorausschauende Wartung – soll Instandhaltung und Administration der Fabriken der Zukunft revolutionieren. Das neue Wartungskonzept soll Risiken für Defekte mithilfe intelligenter Überwachungssysteme bereits erkennen, noch bevor ein tatsächlicher Defekt auftritt.

Edge-Computing wird dabei nicht als Ersatz, sondern als eine Ergänzung zur Cloud betrachtet, die folgende Funktionen bereitstellt:

-

Datenerfassung und -aggregation: Edge-Computing setzt auf die Datenerfassung nah an der Quelle inklusive Vorverarbeitung und Selektion des Datenbestands. Der Upload in die Cloud erfolgt nur dann, wenn Informationen sich nicht lokal auswerten lassen, detaillierte Analysen erforderlich sind oder Daten archiviert werden sollen.

-

Lokale Datenspeicherung: Bei großen Damenmengen ist eine Echtzeit-Übertragung aus dem Kern-Rechenzentrum in der Cloud meist nicht möglich. Umgehen lässt sich dieses Problem, indem entsprechende Daten dezentral am Rand des Netzwerks vorgehalten werden. So fungieren Edge-Gateways als Replica-Server in einem Content-Delivery-Network.

-

KI-gestütztes Monitoring: Edge-Computing ermöglicht ein kontinuierliches Monitoring der angeschlossenen Geräte. Kombiniert mit Machine-Learning-Algorithmen ist eine Statusüberwachung in Echtzeit möglich.

-

M2M-Kommunikation: Edge-Computing wird oft in Zusammenhang mit M2M-Kommunikation eingesetzt, um eine direkte Kommunikation zwischen vernetzten Geräten zu ermöglichen.

Folgende Grafik veranschaulicht das Grundprinzip einer dezentralen Cloud-Architektur, bei der Edge-Gateways als vermittelnde Instanz zwischen einem zentralen Rechner in der Cloud und den IoT-Geräten am Rand des Netzwerks fungieren:

Anwendungsbereiche für Edge-Computing-Architekturen

Die Anwendungsfälle für Edge-Computing entstammen in der Regel dem IoT-Umfeld. Ein wichtiger Wachstumstreiber für Edge-Computing-Technologie ist der steigende Bedarf an echtzeitfähigen Kommunikationssystemen. Die dezentrale Datenverarbeitung wird als Schlüsseltechnologie beispielsweise für folgende Projekte eingestuft:

- Car-to-Car-Kommunikation: Edge-Computing ist wichtig für cloudgestützte Frühwarnsysteme oder autonom fahrende Transportmittel.

- Smart Grid: Dank dezentraler Energiemanagementsysteme soll sich das Stromnetz an Leistungsschwankungen anpassen. Daten, die an Erzeuger transportiert werden, ermöglichen die Reaktion auf Veränderungen im Verbrauch in Echtzeit.

- Smart Factory: Sich selbst organisierende Produktionsanlagen und Logistiksysteme können mit Edge-Computing verwirklicht werden.

Vorteile des Edge-Computings

Im Vergleich zu klassischen Cloud-Architekturen bietet Edge-Computing eine Reihe von Vorteilen:

- Datenverarbeitung in Echtzeit: Die Verarbeitung geschieht näher an den Datenquellen, wodurch Latenz vermieden wird.

- Reduzierter Datendurchsatz: Aufgrund der lokalen Datenauswertung müssen signifikant weniger Daten im Netzwerk übertragen werden.

- Datensicherheit: Compliance-Anforderungen können leichter umgesetzt werden.

Nachteile des Edge-Computings

Trotz der vielen Vorteile gibt es auch beim Edge-Computing Nachteile, die bei der Implementierung berücksichtigt werden sollten:

- Komplexere Netzwerkstruktur: Ein verteiltes System ist komplexer als eine zentralisierte Cloud-Infrastruktur.

- Anschaffungskosten: Edge-Computing erfordert viel lokale Hardware und verursacht somit enorme Anschaffungskosten.

- Wartungsaufwand: Durch die Vielzahl an Komponenten ist sowohl der Wartungs- als auch der Administrationsaufwand nicht zu vernachlässigen.