Apache Spark: Definition und Funktionen

Im Vergleich zu Vorgängern wie Hadoop oder zu Konkurrenten wie PySpark zeichnet sich Apache Spark durch beeindruckend schnelle Performance aus – einer der wichtigsten Aspekte bei der Abfrage, Verarbeitung und Analyse großer Datenmengen. Als Big-Data- und In-Memory-Analytics-Framework bietet Spark zahlreiche Vorteile für Datenanalysen, Machine Learning, Data Streaming und SQL.

Was ist Apache Spark?

Apache Spark, das Datenanalyse-Framework aus Berkeley, gilt inzwischen als eine der beliebtesten Big-Data-Plattformen weltweit und ist ein „Top-Level Project“ der Apache Software Foundation. Die Analytics Engine dient zur gleichzeitigen Verarbeitung großer Datenmengen und Datenanalyseanwendungen in verteilten Computerclustern. Spark wurde entwickelt, um den Anforderungen von Big Data hinsichtlich Rechengeschwindigkeiten, Erweiterbarkeit und Skalierbarkeit gerecht zu werden.

Hierzu bietet es integrierte Module, die für Cloud Computing, Machine Learning, KI-Anwendungen sowie Streaming- und Graph-Daten viele Vorteile bieten. Die Engine findet aufgrund ihrer Leistungsstärke und Skalierbarkeit selbst bei Großanbietern wie Netflix, Yahoo und eBay Anwendung.

Was macht Apache Spark besonders?

Apache Spark ist eine deutlich schnellere und leistungsstärkere Engine als Apache Hadoop oder Apache Hive. Es verarbeitet Aufträge im Vergleich zu Hadoops MapReduce 100-mal schneller, wenn die Verarbeitung im Speicher stattfindet, und 10-mal schneller, wenn sie auf der Festplatte geschieht. Unternehmen bietet Spark somit eine kostenreduzierende und effizienzsteigernde Performance.

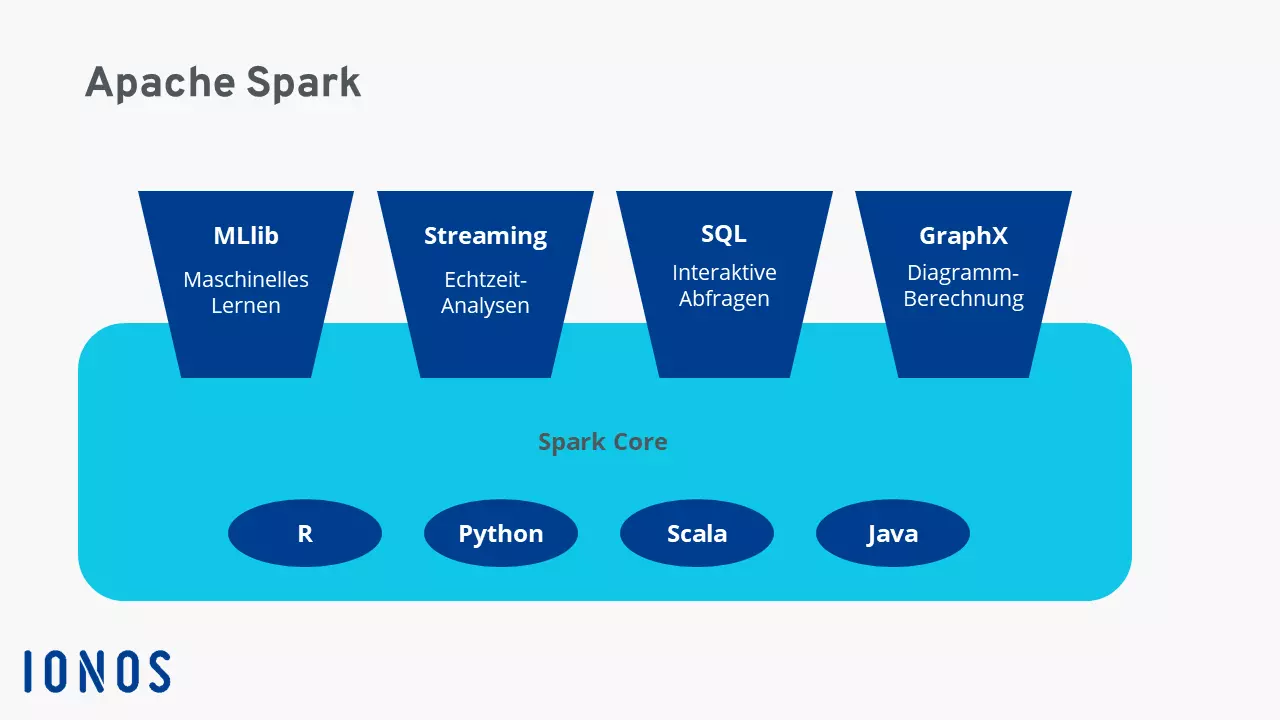

Besonders interessant an Spark ist jedoch die Flexibilität. So lässt sich die Engine nicht nur eigenständig, sondern auch in per YARN gesteuerten Hadoop-Clustern ausführen. Zudem ermöglicht sie Entwicklerinnen und Entwicklern, in verschiedenen Programmiersprachen Anwendungen für Spark zu schreiben. Nicht nur SQL, sondern auch Python, Scala, R oder Java kommen dazu in Frage.

Weitere Besonderheiten an Spark: Es muss nicht auf dem Hadoop-File-System aufgesetzt werden, sondern kann ebenso mit anderen Datenplattformen wie AWS S3, Apache Cassandra oder HBase betrieben werden. Zudem verarbeitet es bei Angabe der Datenquelle sowohl Batch-Prozesse wie unter Hadoop als auch Stream-Daten und verschiedene Workloads mit nahezu identischem Code. Mit einem interaktiven Abfrageprozess lassen sich somit aktuelle und historische Echtzeitdaten inklusive Analyse mehrschichtig auf Festplatte und Memory verteilt sowie parallel verarbeiten.

Wie funktioniert Spark?

Sparks Funktionsweise basiert auf dem hierarchischen Primary-Secondary-Prinzip (veraltet auch noch als Master-Slave-Prinzip bekannt). Hierzu dient der Spark-Treiber als vom Cluster-Manager verwalteter Master-Knoten. Dieser wiederum steuert die Slave-Knoten und leitet Datenanalysen an den Client weiter. Die Verteilung und Überwachung von Ausführungen und Abfragen erfolgt über den vom Spark-Treiber erstellten SparkContext, der mit Cluster-Managern, wie sie Spark, YARN, Hadoop oder Kubernetes bieten, kooperiert. Hierbei werden zudem Resilient Distributed Datasets (RDDs) geschaffen.

Welche Ressourcen für das Abfragen oder Speichern von Daten zum Einsatz kommen oder wohin abgefragte Daten gesendet werden, bestimmt Spark. Indem die Engine Daten direkt im Arbeitsspeicher von Server-Clustern dynamisch verarbeitet, reduziert es die Latenz und bietet eine sehr schnelle Performance. Hinzu kommen parallele Arbeitsschritte und die Nutzung virtueller sowie physischer Speicher.

Apache Spark verarbeitet Daten zudem aus verschiedenen Datenspeichern. Dazu zählen das Hadoop Distributed File System (HDFS) und relationale Datenspeicher wie Hive oder NoSQL-Datenbanken. Hinzu kommt die performancesteigernde In-Memory- oder die festplattenseitige Verarbeitung – je nachdem, wie groß betreffende Datensätze sind.

RDDs als verteilte, fehlertolerante Datensätze

Resilient Distributed Datasets bilden eine wichtige Grundlage in Apache Spark, um strukturierte oder unstrukturierte Daten zu verarbeiten. Dabei handelt es sich um fehlertolerante Aggregationen von Daten, die Spark per Clustering auf Server-Cluster verteilt und parallel verarbeitet oder in Datenspeicher verschiebt. Auch die Weitergabe an andere Analysemodelle ist möglich. Datensätze in RDDs unterteilen sich in logische Partitionen, die sich durch Transformationen und Aktionen abrufen, neu erstellen oder bearbeiten sowie berechnen lassen.

Mit Linux Hosting von IONOS nutzen Sie eine Datenbank nach Ihren Bedürfnissen – flexibel skalierbar, mit SSL und DDoS-Schutz sowie sicheren deutschen Servern.

DataFrames und Datasets

Weitere Datentypen, die Spark verarbeitet, nennen sich DataFrames und Datasets. Bei DataFrames handelt es sich um APIs als in Zeilen und Spalten strukturierte Datentabellen. Datasets wiederum sind eine DataFrames-Erweiterung für eine objektorientierte Benutzerschnittstelle zur Programmierung. Vor allem im Zusammenhang mit der Machine Learning Library (MLlib) spielen DataFrames als API mit einheitlicher Struktur über Programmiersprachen hinweg eine zentrale Rolle.

Welche Sprache nutzt Spark?

Die Entwicklung von Spark erfolgte in Scala, die auch als Primärsprache der Spark Core-Engine dient. Zusätzlich bietet Spark Java- und Python-Konnektoren. Vor allem für Data Science und Data Engineering mit Spark in Verbindung mit anderen Programmiersprachen bietet Python viele Vorteile für eine effektive Datenanalyse. Spark unterstützt zudem High-Level-API-Schnittstellen für die Data-Science-Programmiersprache R, die sich auf große Datensätzen anwenden und für maschinelles Lernen nutzen lässt.

Wo kommt Spark zur Anwendung?

Aufgrund der vielfältigen Spark-Bibliotheken und Datenspeicher, der mit vielen Programmiersprachen kompatiblen APIs und der effektiven In-Memory-Verarbeitung eignet sich Spark für verschiedenste Branchen. Kommt es darauf an, komplexe, große Datenmengen zu verarbeiten, abzufragen oder zu berechnen, bietet Spark durch hohe Geschwindigkeit, Skalierbarkeit und Flexibilität vor allem für Big-Data-Anwendungen großer Unternehmen eine starke Leistung. Beliebt ist Spark daher u. a. in der digitalen Werbung und im E-Commerce, in Finanzunternehmen zur Auswertung von Finanzdaten oder für Investitionsmodelle sowie für Simulationen, künstliche Intelligenz und zur Trendprognose.

Zu den wichtigsten Aspekten für den Einsatz von Spark zählen:

- Verarbeitung, Integration und Sammlung von Datenmengen verschiedenster Quellen und Anwendungen

- Interaktive Abfrage und Analyse von Big Data

- Auswertung von Data-Streaming in Echtzeit

- Maschinelles Lernen und künstliche Intelligenz

- Große ETL-Prozesse

Profitieren Sie von dedizierten Servern mit Intel- oder AMD-Prozessoren an deutschen Standorten und sparen Sie sich eine eigene IT-Abteilung – mit Managed Servern von IONOS.

Wichtige Komponenten und Bibliotheken der Spark-Architektur

Zu den wichtigsten Elementen der Spark-Architektur zählen:

Spark Core

Als Basis des gesamten Spark-Systems stellt Spark Core die grundlegenden Spark-Funktionen bereit und verwaltet die Aufgabenverteilung, Datenabstraktion, Einsatzplanung und die Ein- und Ausgabeprozesse. Als Datenstruktur von Spark Core kommen über mehrere Server-Cluster und Rechner verteilte RDDs zum Einsatz. Zudem bildet es die Grundlage für Spark SQL, Bibliotheken, Spark Streaming sowie alle weiteren wichtigen Einzelkomponenten.

Spark SQL

Hierbei handelt es sich um eine besonders häufig genutzte Bibliothek, mit der sich RDDs als SQL-Abfragen nutzen lassen. Spark SQL generiert zu diesem Zweck temporäre DataFrames-Tabellen. Mit Spark SQL können Sie auf verschiedene Datenquellen zugreifen, mit strukturierten Daten arbeiten sowie Datenabfragen über SQL und andere DataFrame-APIs nutzen. Darüber hinaus ermöglicht Spark SQL die Einbindung der Datenbanksystem-Sprache HiveQL, um auf ein mit Hive verwaltetes Data Warehouse zuzugreifen.

Spark Streaming

Mit dieser High-Level-API-Funktionalität lassen sich hochskalierbare, fehlerresistente Data-Streaming-Funktionen nutzen und kontinuierliche Datenströme in Echtzeit verarbeiten oder darstellen. Aus den Datenströmen generiert Spark einzelne Pakete für Datenaktionen. Auch trainierte Machine-Learning-Modelle können somit in Datenströmen genutzt werden.

MLIB Machine Learning Library

Diese skalierbare Spark-Bibliothek bietet Machine-Learning-Code zur Anwendung erweiterter statistischer Prozesse in Server-Clustern oder zur Entwicklung von Analyseanwendungen. Darin enthalten sind gängige Lernalgorithmen wie Clustering, Regression, Klassifizierung und Empfehlung, Workflow-Dienste, Modellbewertungen, lineare verteilte Statistiken und Algebra- oder Feature-Transformationen. Mit MLlib lässt sich maschinelles Lernen effektiv skalieren und vereinfachen.

GraphX

Die Spark API GraphX dient zur parallelen Graph-Berechnung und vereint ETL, interaktive Graph-Verarbeitung und explorative Analysen.

Wie ist Apache Spark entstanden?

Die Entwicklung von Apache Spark erfolgte im Jahr 2009 an der University of California, Berkeley im Rahmen des AMPlabs. Seit 2010 steht Spark als Open-Source-Lizenz der Öffentlichkeit kostenlos zur Verfügung. Die Weiterführung und Optimierung von Spark begann 2013 durch die Apache Software Foundation. Die Popularität und das Potenzial des Big-Data-Frameworks sorgte dafür, dass die ASF im Februar 2014 Spark zum „Top-Level-Project“ erklärte. Im Mai 2014 wurde daraufhin die Spark-Version 1.0 veröffentlicht. Aktuell (Stand: April 2023) befindet sich Spark in der Version 3.3.2.

Der Zweck von Spark lag in der angestrebten Beschleunigung von Abfragen und Aufgaben in Hadoop-Systemen. Mit der Grundlage Spark Core ermöglichte es durch verteilte Funktionen für Aufgabenübertragung, Eingabe-Ausgabe-Funktionalitäten sowie In-Memory-Verarbeitung, das bis dahin im Hadoop-Framework gängige MapReduce klar zu übertreffen.

Welche Vorteile bietet Apache Spark?

Für die schnelle Abfrage und Verarbeitung großer Datenmengen bietet Spark folgende Vorteile:

- Geschwindigkeit: Workloads lassen sich im Vergleich zu Hadoops MapReduce bis zu 100-mal schneller verarbeiten und ausführen. Weitere Performance-Vorteile entstehen durch Unterstützung für Batch- und Streamdaten-Verarbeitung, gerichtete azyklische Graphen, eine physische Ausführungs-Engine sowie die Abfrageoptimierung.

- Skalierbarkeit: Durch In-Memory-Verarbeitung der auf Cluster verteilten Daten bietet Spark eine bedarfsgerechte flexible Skalierbarkeit der Ressourcen.

- Einheitlichkeit: Spark dient als umfassendes Big-Data-Framework, das in einer Anwendung verschiedene Funktionen und Bibliotheken vereint. Dazu zählen SQL-Abfragen, DataFrames, Spark Streaming, MLlib für maschinelles Lernen und GraphX für Graph-Verarbeitung. Hinzu kommt die Einbindung von HiveQL.

- Nutzerfreundlichkeit: Dank benutzerfreundlicher API-Schnittstellen zu verschiedensten Datenquellen sowie über 80 gängigen Operatoren zur Entwicklung von Anwendungen bündelt Spark zahlreiche Anwendungsmöglichkeiten in einem Framework. Besonders praktisch ist auch die interaktive Verwendung von Scala-, Python-, R- oder SQL-Shells zum Schreiben von Diensten.

- Open-Source-Framework: Durch den Open-Source-Ansatz bietet Spark eine globale, aktive Community aus Expertinnen und Experten, die Spark kontinuierlich weiterentwickeln, Sicherheitslücken schließen und für schnelle Innovationen sorgen.

- Effizienzsteigerung und Kostenreduktion: Da sich Spark auch ohne physische High-End-Serverstrukturen nutzen lässt, bietet die Plattform für Big-Data-Analysen eine zugleich kostenreduzierende und leistungssteigernde Funktionalität – insbesondere für rechenintensive Machine-Learning-Algorithmen und komplexe parallele Datenprozesse.

Welche Nachteile hat Apache Spark?

Trotz aller Stärken weist auch Spark bestimmte Nachteile auf. Dazu zählt in erster Linie die Tatsache, dass Spark über keine integrierte Speicher-Engine verfügt und daher auf viele verteilte Komponenten angewiesen ist. Durch die In-Memory-Verarbeitung sind zudem sehr viel RAM erforderlich, was bei mangelnden Ressourcen die Performance beeinträchtigen kann. Zudem erfordert die Anwendung von Spark eine längere Einarbeitungszeit, um beim eigenständigen Einrichten eines Apache-Webservers oder anderer Cloud-Strukturen mit Spark die Hintergrundprozesse zu verstehen.