AI Token: Definition, Funktionsweise und Berechnung

AI Tokens stellen die kleinste sprachliche Einheit dar, die KI-Modelle benötigen, um Text zu verarbeiten und zu interpretieren. Mithilfe der AI Tokenization wird Sprache in diese Bausteine zerlegt, was die Grundlage für die Analyse und Generierung von Texten bildet. Mit Tools wie dem OpenAI Tokenizer lassen sich die Tokens eines Textes einfach und schnell bestimmen.

Definition: Was sind AI Tokens?

AI Tokens (Artificial Intelligence Tokens) – im Deutschen auch als KI-Tokens bezeichnet – stellen die kleinsten Dateneinheiten von KI-Modellen wie ChatGPT, LLama2 und Copilot dar. Sie sind der wichtigste Baustein für die Verarbeitung, Interpretation und Generierung von Text, denn nur durch die Zerlegung eines Textes in Tokens kann künstliche Intelligenz Sprache verstehen und passende Antworten auf Anfragen der Nutzerinnen und Nutzer liefern. AI Tokens können dabei sowohl einzelne Wörter oder Wortteile repräsentieren als auch Satzzeichen und Emojis.

Aus wie vielen KI-Tokens sich ein Text zusammensetzt, hängt von verschiedenen Faktoren ab. Neben der Textlänge sind in diesem Zusammenhang beispielsweise auch die verwendete Sprache und das genutzte KI-Modell von Bedeutung. Wenn Sie einen API-Zugang wie die ChatGPT API nutzen, bedingt die Anzahl der Tokens zudem, welche Kosten anfallen. In den meisten Fällen rechnen KI-Anwendungen die verbrauchten AI Tokens einzeln ab.

- In Sekunden zur Online-Präsenz

- Mehr Wachstum mit KI-Marketing

- Zeit und Ressourcen sparen

Wie funktioniert AI Tokenization?

Der Prozess, bei dem ein KI-Modell Text in Tokens umwandelt, wird als AI Tokenization bezeichnet. Dieser Schritt ist erforderlich, da Large Language Models natürliche Sprache in einer maschinell analysierbaren Form benötigen. Die Tokenization bildet demnach die Grundlage für Textinterpretation, Mustererkennung und Antworterstellung. Ohne diesen Umwandlungsprozess wäre künstliche Intelligenz nicht dazu in der Lage, Bedeutungs- und Beziehungszusammenhänge zu erfassen. Die Umwandlung von Text in Tokens setzt sich aus mehreren Schritten zusammen und läuft wie folgt ab:

- Normalisierung: In einem ersten Schritt wandelt das KI-Modell den Text in eine standardisierte Form um, wodurch sich die Komplexität und Varianz reduzieren. Im Zuge der Normalisierung wird der komplette Text in Kleinbuchstaben umgewandelt. Außerdem entfernt das Modell Sonderzeichen und beschränkt Wörter mitunter auf Grundformen.

- Textzerlegung in Tokens: Als Nächstes zerlegt die KI den Text in Tokens, also kleinere sprachliche Einheiten. Wie die Textbausteine im Detail aufgeteilt werden, hängt von der Komplexität und Trainingsweise des Modells ab. Der Satz „KI revolutioniert die Marktforschung.” bestand bei GPT-3 noch aus elf Tokens, bei GPT-3.5 und GPT-4 aus neun Tokens und bei GPT-4o nur noch aus acht Tokens.

- Zuweisung numerischer Werte: Im Anschluss ordnet das KI-Modell jedem AI Token einen numerischen Wert zu, der als Token-ID bezeichnet wird. Die IDs sind in gewisser Weise das Vokabular der künstlichen Intelligenz, das alle der dem Modell bekannten Tokens beinhaltet.

- Verarbeitung der KI-Tokens: Das Sprachmodell analysiert die Beziehung zwischen den Tokens, um Muster zu erkennen und Vorhersagen beziehungsweise Antworten zu erstellen. Diese werden auf Basis von Wahrscheinlichkeiten generiert. Das KI-Modell schaut sich Kontextinformationen an und bestimmt nachfolgende AI Tokens immer auf Grundlage der vorherigen.

- 100 % DSGVO-konform und sicher in Deutschland gehostet

- Die leistungsstärksten KI-Modelle auf einer Plattform

- Kein Vendor Lock-in durch Open Source

Wie berechnet man die Tokens eines Textes?

Wie Tokens von der AI berechnet werden, lässt sich mithilfe sogenannter Tokenizer nachvollziehen, die Texte in die kleinsten Verarbeitungseinheiten zerlegen. Sie arbeiten nach spezifischen Algorithmen, die sich an den Trainingsdaten und der Architektur des KI-Modells orientieren. Neben der Anzeige der Token-Anzahl können solche Tools auch detaillierte Informationen zu jedem einzelnen Token bereitstellen, wie z. B. die dazugehörige numerische Token-ID. Dadurch lassen sich nicht nur Kosten besser kalkulieren, sondern auch die Effizienz von Texten in der Kommunikation mit KI-Modellen optimieren.

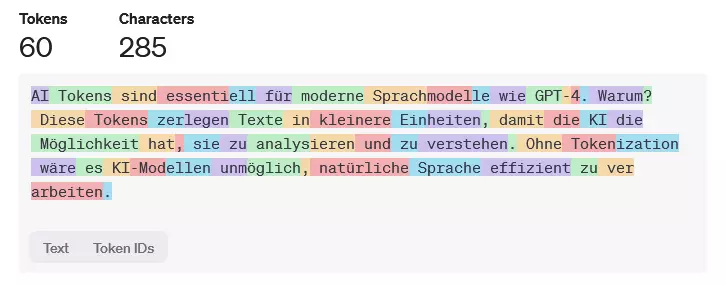

Ein Beispiel für einen frei zugänglichen Tokenizer ist der OpenAI Tokenizer, der für aktuelle ChatGPT-Modelle ausgelegt ist. Nachdem Sie den gewünschten Text in das Eingabefeld kopiert oder eingetippt haben, präsentiert die Anwendung Ihnen die einzelnen AI Tokens, indem es die Einheiten farblich hervorhebt.

Die maximale Textlänge hängt immer vom Token-Limit des jeweiligen Modells ab. GPT-4 kann beispielsweise bis zu 32.768 Tokens pro Anfrage verarbeiten.

AI Tokens und Tokenization: Praxisbeispiel

Um eine bessere Vorstellung von der AI Tokenization zu erhalten, haben wir einen kurzen Beispieltext zur Veranschaulichung verfasst:

AI Tokens sind essentiell für moderne Sprachmodelle wie GPT-4. Warum? Diese Tokens zerlegen Texte in kleinere Einheiten, damit die KI die Möglichkeit hat, sie zu analysieren und zu verstehen. Ohne Tokenization wäre es KI-Modellen unmöglich, natürliche Sprache effizient zu verarbeiten.

Das Modell GPT-4o zerlegt diesen aus 285 Zeichen bestehenden Text in 61 Tokens, was wie folgt aussieht: